現代のストレスと運動不足の常態化する社会環境では、人類史的に形成されてきた私たちの身体との「不適合」を起こしていわゆる「基礎疾患」を蔓延させます。ハーバード大学のリーバーマン先生は「ミスマッチ病」としての「非感染性」の49の症例を指摘しています。

そこで悪化した健康指標の改善(健康づくり)を図るために、「運動-栄養-休養」のライフスタイルの見直しが推奨されるのですが、ライフスタイルの改善はいわば「価値観の転換」が必要でアルコールや薬物の依存症の治療とも共通する困難さが存在しています。例えば毎日の摂取カロリーVs消費カロリーの不等式で150キロカロリーオーバーのケース(例えばご飯一杯とかココア一杯程度)で非活動的な生活を継続すると、1年間で脂肪6Kg相当(1.7g×365日)が増加することとなります。

ですからいわば「今までのライフスタイルを断ち切る」ような「糖質制限ダイエット」のように糖質摂取を ”めのかたき” のように拒否する不健康な方法が横行することとなります。栄養学的にはタンパク質と脂質と糖質の「PFCバランス」を崩した「低カロリージャンクフード」となってしまいます。また脳は糖質(と乳酸)しか利用できないので低血糖症による脳機能低下や筋収縮でのエネルギー源である「筋グリコーゲン不足」による行動能力低下を招いてしまいます(アスリートは絶対にやってはいけません!)。

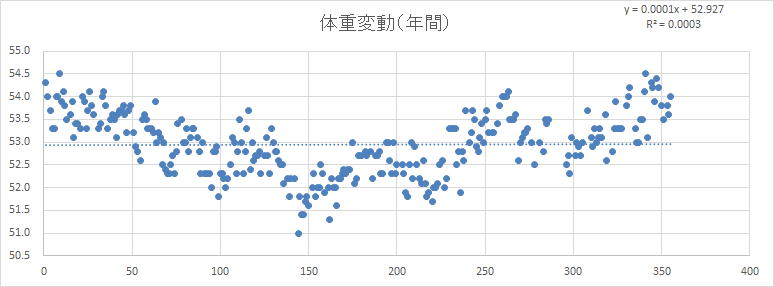

では単純に「運動をすればよいのか?」というと事情は少し複雑となります。デューク大学のポンツァー先生は、狩猟採集民であるアフリカのハッザ族の人も欧米の先進国の人も一日の消費カロリーに大きな差はないという「制限的日次エネルギー消費モデル」を示します(H.ポンツァー:小巻靖子訳、運動しても痩せないのはなぜか、草思社、2022年)。どうやら私たちの身体は「単純な機械」としては動いていないようで、行動パターンや消化吸収機能や身体組織維持・再生プロセスなどを変容させながら「適応」しているようなのです。個人的な経験ですが、私はこの4年間で、月200Kmほど走り三食食べてビールも毎日飲んでいますが、ほぼ6か月周期で年間53~56Kgの体重変動を繰り返しています。

「運動でのエネルギー消費」はひとそれぞれ?

・週末のテニスや野球は「心のリフレッシュ」にとって必要(やめられない)なものなのですが、それだけではメタボリック・シンドロームなどの「基礎疾患」を防ぐことはできないようです。単純に考えると、365日の ”基礎代謝+活動代謝” という「消費カロリー」と食事で摂取される「摂取カロリー」とのバランスで増量や減量は決まるのですが、日常の「生活習慣」としての私たちの年間を通しての行動パターンは意外と意識されていないようです。

・例えば、健康づくりの基準とされる週3~4回20分のランニングをしていても、仕事や家で毎日13時間座っていれば、睡眠時間を除いた残り3~4時間を「どう過ごしていたのか」が問題となりますし、食事などでの摂取カロリーとの関係も問題となります(例えば毎日300Kcalのカロリー消費の余剰があれば33g×365日で年間体脂肪12Kg相当の増加)。米・メイヨークリニックのレヴァイン先生は、同じ体格の人であっても、日常の生活パターンで1日の消費カロリーが2000Kcalも異なること(NEAT:非運動性活動熱生産の動態)を指摘しています。

・ところがデューク大学の人類進化学のポンツァー先生は、「一般的な総カロリー消費量推定法は間違っている」として、単なる機械と異なる私たちの身体は大変に複雑であり、いろいろな要因を加算していっても1日の活動レベルと1日の消費カロリーとはほとんど関係がない・・との見解を示しています。そして、狩猟採集民である活動的なアフリカのハッザの人たちと欧米の人たちとのエネルギー消費量はほぼ同等であるとの測定結果から、1日のカロリー消費量を一定の狭い範囲に収める「制限的日次カロリー消費モデル」を提示します(小巻靖子訳:運動しても痩せないのはなぜか、草思社、2022年)。つまり運動量が増えても、身体はそれ以外の活動にエネルギーを費やすのを控え、1日のカロリー消費量を一定の範囲に抑えるメカニズムが働いていると指摘します。因みに、運動に対する適応としての「エネルギー効率の改善」はエネルギー消費量を若干低下させることが考えられますが、「訓練」と「技術」の影響は予想外に小さいことも指摘しています。

・運動生理学的には、同一距離を同一速度で走った場合の消費エネルギーは「体重」の影響がありますが、実際には発汗による体重減少やランニングスキルの運動効率を改善する工夫など様々な要因が複雑に絡んでくる(ストライドを抑えてハイピッチ走法に転換するとか「カーボンプレート入りの厚底シューズ」に履き換える:数%ランニング効率が改善される場合がある)ため「ひとそれぞれの」カロリー消費量となっているようです。

「エクササイズ」と「スポーツ」とは違うのですか?

ハーバード大学の著名な進化生物学者・リーバーマン先生の最新刊「運動の神話」が出版されました(中里京子訳:早川書房、2022年)。現題は ”Exercised” です。

「身体運動-骨格筋がエネルギーを使って生み出すあらゆる身体動作。エクササイズ-健康とフィットネスの維持・向上を目的として行われる、計画的で構造化された、反復を伴う自発的身体活動。エクササイズド-イライラさせられる、心配な、不安にさせられる、悩まされる。」との書き出しで始まり、「だが何より、運動は不安と混乱の元となった。なぜなら、運動が健康に良いことはわかっていても、十分かつ安全に楽しく運動することができない人が大部分だからだ。私たちは、運動に悩まされているのである。」と指摘しています。

前作の「人体600万年史(塩原通緒訳:早川書房、2015年)」では、狩猟採集民として進化してきた私たちが、現代社会における身体活動の不足により ”ディスエボリューション” としての「非感染性のミスマッチ病(49の症例)」を引き起こしていることを指摘していました。

米・メイヨークリニックのレヴァイン先生は「座りっぱなしが死を招く(GET UP!)」というセンセーショナルな書籍(鈴木素子訳:角川書店:2016年)で、13時間以上座っている生活習慣に対して、意図的なエクササイズ運動(EAT:運動性活動熱生産)以外でのNEAT(非運動性活動熱生産)の重要性(消費カロリーが500~2000Kcal程度増加する)を指摘しています。週末にテニスをやったりジムで週数回エクササイズを実施するだけでは十分な身体活動量を確保できないということのようです。

「エクササイズ」は、メタボリックシンドロームやロコモティブシンドローム・フレイル(虚弱)などの改善のための有酸素能力向上や筋(力)の増加などを目的として定期的に計画・実行されます。ただ、エアロバイクやランニングベルトでの有酸素運動やバーベルやマシンによる筋力トレーニングなどが「楽しいかどうか」には個人差があるように思います。一方ストレッチングやヨガやティラピスなどはリラックス感が得られるので「快い」もののようです。

どうやら、スポーツは 「楽しい」からやるようなのですが健康状態の改善にどの程度貢献しているのかは不明確です。一方エクササイズは「やらないと不健康になる!」という強迫観念があるので逆説的に「楽しくないのでやらなくなる」ようなのです。実は、文部科学省の「日本人の運動実施状況」に関するデータは、「階段上り」やウォーキングや筋トレも含めて「スポーツ実施」と同等に扱っているようで「楽しくやるスポーツ」と「いやいややるエクササイズ」を同等に評価しているようです。(続く)

「フェイント」や「フェイク」は必要なのですか?

ボールゲームの一対一の場面では、オフェンス側は相手との関係性から幾つかの「選択肢」を実行します。相手との距離が近づいてくるとオフェンス側は、右へ行くような「そぶり」を見せて相手に右側を守るような行動を誘発します。ディフェンス側の右側への反応が起これば「ワンフェイク」で左側へボールを運びますし、相手が既に「ワンフェイク」を予測している「そぶり」があれば「ツーフェイク」で再び右側にボールを運びます。

面白いのは「ノーフェイク」といって、ディフェンス側がフェイクを予測している場合にはそのままダイレクトに右側へボールを運ぶとディフェンスを振り切ることができます。

これらの現象は反応時間における「不応期」として説明されます。私たちの身体は質量が大きい(重たい)ので、事前に特定の方向に行動を起こすよう脳や脊髄を経由して筋収縮の準備をしています。そして「絶妙のタイミング」で反応を開始します。予測が正確であれば相手のコースを止めることができますが、相手の仕掛けてくる方向が読めないときや相手のフェイントに惑わされてしまうとボールを止めることができません。

実は反応時間においては、光刺激に対してすばやく跳びあがる「単純反応時間」にはあまり個人差がないことが分かっています(0.2~0.3秒くらい)。ところが光刺激が提示されるタイミングを予測すると当然それ以下で反応することができます。陸上競技のスタートではピストルの音から0.1秒以内にスターティングブロックに一定以上の力を加えるとセンサーが反応して失格(フライング)となります。しかし「真面目に反応する」と0.08秒ほどで反応できる選手が一定数存在します(2008年NHK放映、反応の限界)ので、こういった選手は失格しないように「人並みにスタートする」練習をします。100mは「反応時間競争」でも「一歩目競争」でも「30m競争」でもないので「トータルとして100mの記録」が最終課題となります。

「刺激提示」から動作システムを起動させ運動指令が脊髄経由で「筋収縮を開始」されるまでを「反応時間」といいます。さらに筋収縮で動作が開始されて課題達成されるまでを「反応動作時間」といいます。「反応時間」にはあまり大きな個人差はないのですが「反応動作時間」は筋収縮のパワーや動作の巧拙により個人差が生じます。さらに「予測付き反応時間」になると「予測精度」の問題もあり大きな個人差(運動場面での経験の差)が生じます。

つまりボールゲームなどでのいわゆる「反応のセンス」は、数多くの運動経験による予測の精度やトレーニングによる身体動作の速度や巧拙(スキル)が複雑に関連して決定されていることとなります。

ボールゲームの「センス」って何ですか?

あのプレーヤーは「センスがいい!」と言われることがよくあります。一方「今のプレーはセンスが悪い?」とも言われることがあります。そういわれると「何となく?」わかったような気もするのですがその実態は何なのでしょうか?

サッカーでは、3大B(Ball Control と Body Balance と Brain Work)やTIPS(Technique と Intelligence と Personality と Speed)の重要性が指摘されています。多分「センスがある」ということの基本にはこれらのことが関連しているのだと思います。またスポーツにおける3大T(Training と Technique と Taktics)という指摘もあります。ベテランアスリートのように技術的にはそれほど問題はなくとも体力的な出力レベルが維持できないケースもあり、実際のパフォーマンスとしては「体力不足」と評価されることとなります。

ではトレーニングによって体力レベルを向上させればパフォーマンスは改善されるのでしょうか?

答えは「ノー」です。実は技術的な課題は身体的能力と密接に関連して変容してゆきます。ゲーム後半にはスピード持久力は低下してきますので、前半と同じような「ボールスキル(技術×身体能力)」は発揮できなくなりますので他の選択肢が要求されます。実はこのことが本来の「センスがある」という表現につながっているように思うのです。

今まで指摘してきたように、私たちの運動司令は「結果を予測して発せられている」ようですので、「このステップでは相手をかわせない」と他のステップに切り替えるケースと同じステップを繰り返してボールを奪われるケースとが生まれます。前者は「センスがある」、後者は「センスが悪い」ということになるのでしょうか? ドイツのシュライナー先生は「サッカーのコーディネーショントレーニング(大修館書店、2002年)」において、「ある運動を行う際に、それがうまくいくように神経や筋肉が協調して働くこと」との視点から様々なトレーニング(ドリル)を提示しています。(続く)

ランニング時も「結果を予想して」走っている?

私は週5日ほど走っているのですが、走り出す前に「何となく」シューズを選びます(薄底や厚底など数種類)。また、W-upを兼ねて1Km7分ほどのペースで走り出すのですが、1.5Km地点でその日のペースが「何となく」決まります。そのまま㌔7分のこともあれば6分30秒に上げる場合もあります。

私はC社製の加速度計(モーションセンサー)を利用して、ストライド・ピッチ・接地時間や接地のタイミング・減速量・下肢のバネ係数などを250m単位で記録しています。面白いのは、同じ感覚(例えば㌔7分ピッチ182歩/分)で走っているつもりなのですが250m毎に見てみるとかなり変動しているのです。路面状況も違えばその日の体調も前半-中半-後半で違うので当たり前といえば当たり前なのですが「結果が㌔7分182歩/分となるように予想して」走っているようなのです。

おそらくレース中であっても「自分の現在の状態と後半のコンディション」などを予測してランニングスキル(ここからはピッチ走法を意識するとか・・)を決定しているようです。「予想通り」であれば「結果との誤差( ”サプライズ” といいます)」が少なくなり「ドーパミン報酬系」が働くと考えられています。一方あまり良い結果が予想されないときは「それなりに」対応して「纏めている」ものと思われます。

レースでも、スタートしてから数キロ経過し「なんとなく今日は行けそう・・」との予感がして、レース中盤からストライドを抑えてピッチを上げてペースアップをし、そのことが心理的高揚感(”よ~し、このままいければ久しぶりのベストタイムが出る”・・このプロセスはエネルギー供給系でのグリコーゲン動員力も高まります)を伴って達成感と充実感と幸福感を感じながらゴールすることができるのだと思います。

この「予測」と「経過」と「結果」の誤差が少なくなることは「経験知」の積み重ねで改善して行くようで、マラソンの川内優輝選手の異例のレース出場頻度が高いこともトレーニングと割り切れば納得できるような気もします。

また「集団走」をしていると集団なりの固有のリズムが生まれてくるようで「ミラーニューロンシステム」が働いているのかもしれません。「他者との情動の共有」も生じますので他者を知覚-理解する能力に関わる集団性や社会的スキルも生ずるようです(リゾラッティ、2020年)。ですから、実際のレース中ではそのリズムが自分のリズムと合わないと判断すると集団から離れたりもします。実は「同じストライド×同じピッチ=同じスピード」で走り続けているといわゆる「中枢性抑制」がかかりパフォーマンスが低下する可能性(山崎、2015年)があるので、給水時に一瞬ペースアップしたり集団から離れたりするケースもあるようです。

「運動司令」と「運動イメージ」と「ミラーニューロン」

どうやら運動司令は「結果を予測して」発せられているようなのですが、では「何を手掛かり」にして予測しているのでしょうか?

「予想脳」の藤井直敬先生も「能動的推論」の乾・坂口両先生も、外界からの絶え間ない感覚情報が重要で、視覚や筋感覚などの「感度調整」をして予測の精度を上げていることを指摘します(藤井直敬、予想脳、2005年:乾敏郎・坂口豊、脳の大統一理論、2020年)。まさに「注意・集中」をして状況を把握することが重要ということのようです。

一方、実行する運動司令は各関節を「どの位動かすのか」という「関節トルク」(”グン”と蹴る”のか”ポン”と蹴るのかというイメージ)で発せられているようです(川人光男、運動軌道の形成、1986年)。

では「運動を実行するイメージ」はどうなのでしょうか?

リゾラッティ先生らの「ミラーニューロン」(リゾラッティとシニガリア、ミラーニューロン、2020年)では、「目前で他人が動く視覚情報」が自分の動きを誘発する「模倣」が背景にあるようで、その意味では「人の振り見てわが振り直せ」なのですが、人の振り見て生ずる「運動イメージ」の実体は何なのでしょうか?

個人によって異なるとは思いますが、「一人称的イメージ」は「自分目線での自分の運動感覚」ですし「二人称的イメージ」は「あなたと私が一緒に動く運動感覚」ですし「三人称的イメージ」は「自分と関わりのない(わからない)運動感覚」があるように思います。世阿弥の有名な「離見の見」と「我見の見」もこれと関わっているように思われ、「我見の見」は自己満足の戒めとされていますが、「離見」と「我見」が揃っていて初めて熟達の境地に達するようにも思います。実はミラーニューロンには「自分が他人から真似されている」ことに反応する性質もあるようです。

「ミラーニューロン」による「模倣」で想起される実際の運動イメージは「自分目線の一人称または二人称」であり撮影された外的映像のような「他人目線の三人称」ではないように思うのです。

ただ、ヒトのミラーニューロンは「サルの猿真似」よりは少し高度な機能を持っているようで、ミラーリング時には休止していてその後活動する「スーパーミラーニューロン」がある可能性(階層性を持っている)も指摘されています(イアコボーニ、ミラーニューロンの発見、2009年)。「形をまね」「動作をまね」「目的をまね」て、「見よう見真似」で対応しているうちに「わがものに置き換わる」メカニズムはまだ良く分かっていないようです。

運動司令は「結果を予測」して発っせらている?

私たちが運動に熟練してくると、どうやら結果を予想して動作パターンを選択して実行しているようです。

例えば雪の路面や登山道を走る時は、身体の移動状況や視覚情報など様々な入力情報から転倒しないように接地や体重移動を調整しているようです。

京都大学の乾敏郎先生と電気通信大学の坂口豊先生は「すべての脳機能は推論である」とするフリストン先生(英)の「自由エネルギー原理」を解説し、知覚や認知、運動といった機能が統一的に説明できることを指摘しました(乾敏郎・坂口豊、脳の大統一理論、岩波書店、2020年)。つまり「知覚」の仕組みは、中枢【信念】の予測信号と感覚受容器からの感覚信号とが「予測誤差信号」を生成し、それが中枢に対して【信念の更新】を要求し、実際の結果と予測との誤差【サプライズ】が小さくなるように働くシステムがあるようなのです。

理化学研究所の藤井直敬先生も「予想脳(Predicting Brains)」という概念で、自己をとりまく環境を逐次理解し、外界と整合性のある行動をとることにより「次に生ずる未来を常に予測して、絶えず流入してくる自動処理された外界環境情報と自己が予想した未来とを比較することが、脳の本質的な機能である」と指摘します(藤井直敬、予想脳、岩波書店、2005年)。

確かに、スキーで不整地斜面を滑ったりスラロームで難しいセッティングをクリアしたりする時には、予想と結果とを常に比較していると思うのです。その意味で、運動に「熟練する」ということはこのメカニズムが使えるようになっており、運動がうまく実施できないのは「経験知」が足りないからなのかもしれません。運動が上手くいかないのは「何が起こるかわからない・・!」という不安感が存在するためで、別の場面での経験知を適用して何とか乗り切るのもこのような脳のメカニズムと関連しているのかもしれません。

「出来合いのもの」で対応する・・転移?

「模倣」ではなく「転移」と指摘される現象もあります。そもそも私たちの身体は骨や関節や筋肉はほぼ同じ(たまに骨や筋肉が退化している人もいる)ですので、プロポーションやパワーの違いはあるもののほぼ似たように動きます。

例えばテニスをずっとやっていた人が初めてバドミントンをやってみる(私はそうでした)と、最初はテニスの「サービス」や「スマッシュ」の動作で対応します。バドミントンのラケットはテニスに比べて軽い(300gと80g)ので操作はし易いのですが「何か変?」です。そのうち「動作の変容(適応?)」が起こりバトミントンのラケットやシャトルの特性に合わせて何とか打てるようになります。現在のラケットは前後左右の「撓り」だけではなく「ねじれ」にも対応していますので「バックハンドのハイクリア」で瞬間的にラケットヘッドを「捻る」というテクニックも存在します。これはテニスラケットではできないテクニックなので「新たに習得」する必要があります。

私が授業でバドミントン部員と試合をしていたら「先生のコースなんか変です!」と言われました。どうやらテニスの配球のセンスでバドミントンをやっていたようなのです。そういえば卓球選手(ペンホルダーの速攻タイプやシェイクハンドのカットマン)やソフトテニス選手のバドミントンも「なんか変!」でした。

これは私の仮説の一つである「動作パターン浮動(MPD)」(運動野-小脳-視床-大脳基底核でのループ制御)とも関係しているのかもしれません。大脳の神経細胞(ニューロン)が160億個ほどであるのに対して小脳は690億個あるとされ多様な「動作補正」を支えています。そして「これだ!」という補正を大脳基底核が視床を介してONにする(脱抑制といいます)メカニズムです。更にその補正が「予測通りうまく行く(補修予測誤差ゼロ)」と「中脳」から報酬に関わるドーパミンが大脳基底核線条体に放出され「強化学習」が進んでゆくようです。

当初は「出来合いのパーツ」を使って処理していくうちに「バージョンアップ」が進んでゆくようですが、では元々の「ピュアなスイング」はどうなってしまったのでしょうか。大学院の授業で、野球の投手とこの話をしていたら「スライダーを覚えたら今までのピュアなカーブが投げられなくなりました!」とのコメントがありました。

「見よう見真似で・・」何とかできる?

私たちが、自分の経験したことのない運動をやってみようとするときは一体どうやって実行しているのでしょうか?

1990年代にイタリアのリゾラッティ先生らが発見した「ミラーニューロン」という脳の運動前野というところにある神経細胞があります。これは実験でサル自身が運動を実行する(目の前の餌をとって食べる)ときとサルの目前で実験者が食べ物(偶然ジェラードだったらしい)を食べるときのどちらにも反応する神経細胞で、見えた行為の方向や実験者の手の動きに影響されているようなのです(リゾラッティとシニガリア、ミラーニューロン、紀伊国屋書店、2023年)。

これは俗称「真似っこニューロン」と呼ばれているもので動物や人間の「模倣行動」に関係しているようで、子どもが物真似をしながら様々な行動を学習してゆく基礎とも考えられていますす。そして模倣にも段階があるようで、腕などの形を真似る階層から目標達成の動作レベルでの階層、そして動作の目標を模倣するという階層を経過するようなのです。

バドミントンに例えれば、ラケットの構え方や動かし方の模倣から、ハイクリアの動作の模倣を経て目標である相手コートに深く打ち返す、という段階を経るようです。

更に運動を模倣するだけではなく「予測」を含めて運動を要素に分解し、他の類似の運動とも区別ができてその運動が実行できるようになるようです(松波謙一、運動と脳、サイエンス社、2000年)。また、予想と結果の「ズレ」が少ないことは「報酬予測誤差ゼロ」という中脳からのドーパミン作動性の「報酬系」を活動させいわゆる「強化学習」を成立させてもいるようです(木村實、大脳基底核、NAP、2000年)。

まさに山本五十六の「やってみせ、言って聞かせて、 させてみせ、 ほめてやらねば、人は動かじ。」というお話を思い出しました。

実は人類進化のプロセスで、狩猟活動を行っていた170万年ほど前のホモ・エレクトス段階でのヤリや石器の製作や訓練として行う投擲動作の反復などでもこの「ミラーニューロン」が関与して「強化学習」が背景にあったことも推察(妄想?)されます。祭祀での祈りや踊りもこの「模倣」が背景にあったとすれば宗教的行動や文化的行動や「遊び」の発生にも関連しているのかもしれません。